5. fejezet - Bázisfüggvényes hálózatok

Az előzőekben bemutatott MLP hálózatok számos előnyös tulajdonságuk és széleskörű alkalmazásuk ellenére hátrányokkal is rendelkeznek. A hátrányok között első helyen kell megemlíteni, hogy az MLP hálózatok paramétereikben nemlineáris leképezést valósítanak meg. Ennek következménye, hogy az MLP hálózatok kritériumfelülete még a szokásosan alkalmazott négyzetes hibafüggvény mellett sem kvadratikus, a hibafelület lokális minimumokkal rendelkezhet. A lokális minimumok lehetősége miatt a gradiens alapú hibavisszaterjesztéses tanító eljárás (és bármely más gradiens alapú eljárás) nem garantálja, hogy a globális optimumot elérjük. További hátrányuk a tanító eljárás viszonylagos lassúsága, ami különösen nagyméretű hálózatoknál és elsősorban olyan alkalmazásoknál jelent komoly nehézséget, ahol nem csupán off-line tanulásra lehet szükség, hanem ahol a hálózat működését folyamatosan a változó környezethez kell igazítani. A lassú tanulás fő oka a több tanítható réteg és az ebből következő hibavisszaterjesztés szükségessége. A tanítás gyorsítható, ha a tanítható rétegek számát csökkenteni tudjuk.

Az 1. fejezetben összefoglaltuk azokat az elméleti eredményeket, amelyek megmutatták, hogy minimum két aktív rétegre szükség van ahhoz, hogy a hálózat megfelelő függvény-approximációs képességekkel rendelkezzen. A következőkben olyan hálózatokkal fogunk foglalkozni, amelyekben szintén két aktív réteg található, az egyik aktív réteg szerepe azonban jelentősen különbözik az eddig tárgyalt MLP hálózatoknál betöltött szereptől. A szokásos tanító eljárással csak a hálózat kimeneti rétegét tanítjuk, lehetővé téve így a gyorsabb tanulást. Ennek ellenére e hálózatok lényegében hasonló képességeket mutatnak, mint a többrétegű perceptron (MLP) hálózatok.

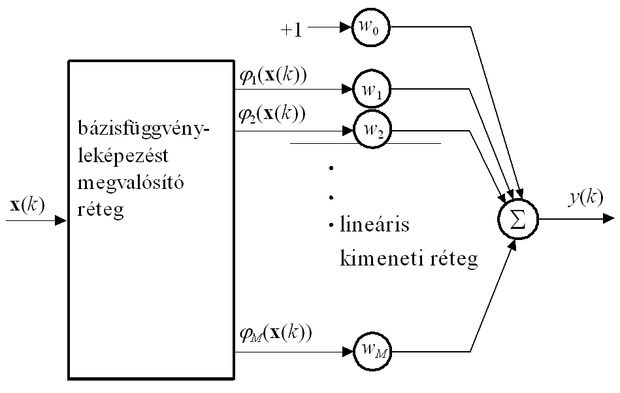

A családba tartozó hálózatok alapvető felépítése − bár a hálózatok eltérő eredetűek, és egymástól függetlenül jöttek létre − hasonló. A hálózatok két rétegből állnak (5.1 ábra): egy nemlineáris leképzést megvalósító rétegből (amely a család egyes tagjainál rögzített, más esetben ez is tanítható, azonban a tanítás itt egyes hálóknál felügyelet nélküli, más hálóknál felügyelt eljárással történik) és egy felügyelt tanítással tanítható lineáris rétegből. E hálózatok tehát megtestesítik a 2. fejezetben bemutatott esetet, amikor a hálózat által modellezett rendszer két egymást követő leképezést valósít meg: egy nemlineáris és egy lineáris leképezést.

A család minden tagjánál a kimeneti réteg, amely lineáris súlyozott összegzést végez, ellenőrzött tanítású, ahol a súlyok meghatározása a szokásos LMS algoritmussal történhet. A nemlineáris leképzést az első réteg valósítja meg. Ennek felépítése − bár az egyes hálótípusoknál jelentős különbségek találhatók − abból a szempontból minden bázisfüggvényes hálónál hasonló, hogy a bemenet nemlineáris transzformációját mindegyik típus bázisfüggvények alkalmazásával végzi. Ezért az egész hálózatosztályt szokás bázisfüggvényes hálózatosztálynak nevezni. A bázisfüggvényes hálózatok által megvalósított leképezés általános formája egykimenetű hálózatot feltételezve:

( 5 . 1 )

A bázisfüggvényes hálózatok konkrét típusai a i=1,…M bázisfüggvényekben térnek el egymástól. A hálók konstrukciójánál olyan bázisfüggvények alkalmazása jöhet szóba, melyekkel valamilyen általános képesség megvalósítható. Az 1. fejezetben láttuk, hogy a bázisfüggvényes hálóarchitektúra is működhet univerzális approximátorként , vagyis, amikor egy megfelelő méretű és megfelelő tulajdonságú bázisfüggvényekkel dolgozó háló tetszőleges pontossággal közelíthet egy folytonos függvényt (1.6 tétel).

A bázisfüggvényes hálócsaládba tartozó leggyakrabban alkalmazott hálótípus az RBF háló, ahol radiálisan szimmetrikus bázisfüggvényeket alkalmazunk. Ebbe a függvénycsaládba tartoznak pl. a Gauss függvények vagy a B-spline függvények is. A radiális függvényeken kívül további függvények (pl. wavelet [Zha92], [Zha97]) alkalmazásával is születtek bázisfüggvényes hálók.

A bázisfüggvényes hálókon belül megkülönböztethetünk paraméteres bázisfüggvényekkel, illetve rögzített bázisfüggvényekkel dolgozó hálókat. Az előbbieknél a bázisfüggvények paramétereit szintén a tanuló eljárás részeként kell meghatározni. E hálókra az is jellemző, hogy az általuk megvalósított leképezés a bázisfüggvények paramétereire nézve már nem lineáris. A bázisfüggvények paramétereinek meghatározása lehetséges ellenőrzött tanítással, de egyes esetekben nemellenőrzött tanítás is alkalmazható, sőt van olyan eset is, amikor a bázisfüggvények paraméterinek meghatározása a mintapontoktól függetlenül történik.

A bázisfüggvényes hálózatok más megközelítésben az egyszerű perceptron kiterjesztéseiként is vizsgálhatók. Láttuk, hogy a perceptron a bemeneti minták lineáris kétosztályos szeparálására képes. A gyakorlati feladatok döntő részénél azonban a lineáris szeparálás nem elegendő: a mintákat csak nemlineáris felülettel tudjuk szétválasztani. A perceptron működése kiterjeszthető, ha a bemenetére kerülő mintákat előbb nemlineáris transzformációnak vetjük alá azzal a céllal, hogy a transzformáció következtében létrejövő mintapontok már lineárisan szeparálhatók legyenek, tehát a transzformált tartományban a feladat perceptronnal megoldható legyen. Ha e transzformáció során az eredetileg N- dimenziós mintateret egy ( M > N )-dimenziós tartományra képezzük le, akkor a mintapontok számának a dimenzióhoz viszonyított arányát csökkentjük, ami a perceptron kapacitásánál(3.1.3. alfejezet) bemutatottak szerint növeli a lineáris szeparálhatóság esélyét. Kellően nagymértékű dimenzió-növelés mindenképpen biztosítja a lineáris szeparálhatóságot [Cov65].

A bázisfüggvényes hálózatoknál − amennyiben csak a kimeneti réteg paramétereit tanítjuk − a tanulás folyamata gyorsabb, mint az MLP hálózatoknál. A nagyobb sebességnek két oka is van: egyrészt a módosítandó súlyok száma általában kisebb, és minthogy nincs szükség hibavisszaterjesztésre, egy tanítási lépés rendszerint kevesebb számítást igényel; másrészt a megfelelő képességű hálózat kialakításához szükséges tanító lépések száma is kisebb. Általánosságban azt mondhatjuk, hogy e hálózatok képességei hasonlóak a többrétegű perceptron képességéhez, ezért számos alkalmazásban az MLP hálózatok reális alternatíváit jelentik.

A következőkben a bázisfüggvényes hálózatok két fontos típusával, az RBF és a CMAC hálózatokkal foglalkozunk. Bemutatjuk a hálózatok felépítését, a hálózatok létrehozásának lépéseit, a főbb tulajdonságait, legfontosabb előnyeit és hátrányait.